Inception Labs が新たな拡散型大規模言語モデル「 Mercury 」を発表し、AI 業界で大きな注目を集めています。

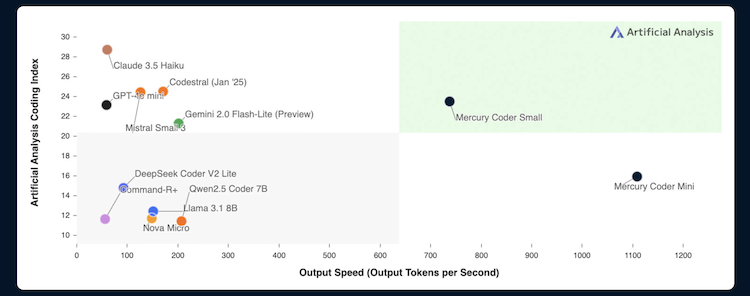

Mercury は、従来の Transformer ベースの自己回帰型モデルとは異なり、画像生成 AI で使われてきた拡散モデル( diffusion model )の技術をテキスト生成に応用した「 Diffusion LLM ( dLLM )」です。最大の特徴は、従来の LLM と比べて最大 10 倍という圧倒的な生成速度で、NVIDIA H100 GPU 上で 1 秒あたり 1000 トークン以上を処理できる性能を誇ります。これは Transformer モデルの約 5 倍以上のスピードとなります。

従来の自己回帰型モデルでは、トークンを左から右へ順番に生成するため、前のトークンが完成しないと次のトークンを生成できないという制約がありました。これに対して Mercury は、ノイズから始めて複数の「ノイズ除去」ステップを経て並列的に処理することで、「粗から細へ( coarse-to-fine )」のアプローチを実現し、生成速度を劇的に向上させています。

さらに注目すべきは、この高速化を実現しながらも出力の品質を維持している点です。Inception Labs によると、同社がまず提供を開始した「 Mercury Coder 」(コード生成に特化したモデル)は、標準的なコーディングベンチマークで GPT-4o-mini や Claude 3.5 Haiku といった高速最適化モデルと同等かそれ以上の性能を発揮するとのことです。Copilot Arena のベンチマークでは、Mercury Coder Mini が 2 位タイという好成績を記録しています。

拡散モデルをテキストに適用する際の課題を解決するため、Inception Labs は「 Score Entropy 」という新しい損失関数を開発。これにより、離散データであるテキストに対して拡散プロセスを効果的に適用できるようになり、従来の技術的障壁を突破しました。

Inception Labs はスタンフォード大学、UCLA、コーネル大学の教授陣(スタンフォードの Stefano Ermon 教授が関与)が設立したカリフォルニア拠点のスタートアップで、拡散モデルに関する先進的な研究を基盤としています。現在は「 Mercury Coder 」を無料のプレイグラウンド( chat.inceptionlabs.ai )でテスト可能であり、エンタープライズ向けに API とオンプレミス導入を提供しています。また、チャットアプリケーション向けモデルはクローズドベータ段階にあり、将来的には複雑な計画立案や長文生成が可能な高度なエージェント機能を備えたモデルも計画しているとのことです。

筆者の視点:これまで、ほとんどの LLM は Transformer モデルを採用してきました。しかし、今回、画像生成で使われる Diffusion モデルを LLM に応用することで、性能を維持しながら圧倒的な処理速度を実現したとのこと。この技術がさらに発展し、コーディングだけでなく通常のチャット機能にも応用されるようになれば、CPU ではなく GPU を活用して現在の AI ブームの火付け役となった「ディープラーニング・モーメント」に匹敵する技術革新になる可能性も秘めています。